从逻辑电路到二进制编码:编程为何只使用0和1?

在计算机科学中,编程语言的基础是二进制编码,即使用0和1来表示数字和字符。为了理解为什么编程只使用0和1,我们需要回顾一下计算机系统的基本构成以及二进制数的特性。

计算机的内部由许多电子元件组成,其中最基本的元件是称为“逻辑门”的电路。逻辑门根据输入电压的不同产生不同的输出,这种基本的逻辑运算形成了计算机的基础。在逻辑门中,最常见的有与门、或门和非门。

现代计算机使用的逻辑门以及其他组件,都是基于晶体管的。晶体管是一种能够控制电流流动的电子器件,它能将电流的流动与不流动表示为0和1。通过将多个逻辑门连接在一起,可以构建复杂的电路,实现各种计算和处理任务。

在二进制系统中,数字和字符都可以用0和1来表示。这是因为计算机内部的逻辑电路只能处理两种状态:通电或不通电,也就是高电平或低电平。通过将多个二进制位组合在一起,就可以表示更复杂的数值和字符。

使用二进制编码的优势在于简单和可靠。二进制编码只有两个状态,易于实现和理解。由于只有两种可能的状态,容易避免由于噪声和干扰引起的误判。这使得二进制编码成为计算机系统的基础,并广泛应用于计算机硬件和软件中。

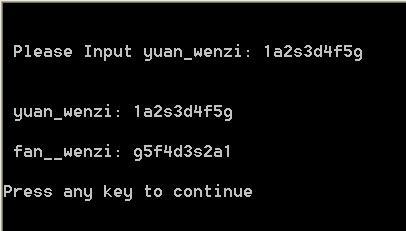

从逻辑电路和二进制编码的角度来看,任何信息都可以用0和1来表示。与二进制编码相关的一个概念是ASCII码,它是一种用于表示字符的标准编码系统。ASCII码将字符映射到一个唯一的二进制数值,使得计算机可以处理和显示各种字符。

当我们使用编程语言时,实际上是在用特定的语法和规则来操作二进制编码。编译器或解释器将程序中的指令转换为特定的机器码,然后计算机执行这些机器码来完成相应的任务。

尽管在编程中使用0和1是必要的,但不要将其与实际编程语言的语法混淆。现代编程语言提供了更高级的抽象层次,使得开发人员可以更方便地编写代码,并且不必直接处理二进制编码。

总结而言,编程中使用0和1是为了与计算机内部的逻辑电路和二进制编码相对应。二进制编码为计算机提供了简单和可靠的方式来表示和操作数字和字符。尽管编程语言提供了更高级的抽象层次,但了解底层的二进制原理对于理解计算机系统以及高效编程仍然是非常重要的。

版权声明

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。