HDFS编程配置指南

Hadoop分布式文件系统(HDFS)是Apache Hadoop生态系统中的一个关键组件,它被设计用于在集群中存储大规模数据集。编程配置HDFS是为了能够使用Hadoop的API来读取和写入HDFS中的数据,并以高效和可靠的方式处理大数据量。以下是HDFS编程配置的一些建议和指南。

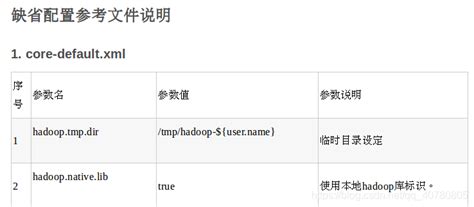

1. 配置Hadoop集群和HDFS:在进行HDFS编程之前,首先要确保正确配置Hadoop集群和HDFS。所有节点上的hadoop配置文件(如coresite.xml和hdfssite.xml)应该被正确设置,并且每个节点都能够正确通信。

2. 了解HDFS的基本概念:在编程HDFS之前,熟悉HDFS的基本概念是很重要的。这包括了文件和目录的概念、块大小、副本系数等。这些概念将帮助你更好地理解和利用HDFS的能力。

3. 使用Hadoop的API进行操作:Hadoop提供了多种API来操作HDFS,包括Java API、HDFS shell命令和Hive等。根据你的需求选择适当的API,并学习如何使用它们来读取和写入数据、创建和删除目录等操作。

4. 配置读写权限:HDFS具有访问控制机制,你可以在文件或目录级别上配置读写权限。在编程HDFS时,需要确保你有足够的权限来操作目标文件或目录。你可以使用hadoop fs chown和hadoop fs chmod命令来更改文件或目录的所有者和权限。

5. 处理异常情况:编程HDFS时,经常会遇到各种异常情况,如文件不存在、写入失败等。为了确保代码的正确性和健壮性,必须处理这些异常情况。在代码中使用trycatch语句来捕获异常,并根据具体情况采取适当的错误处理措施。

6. 优化性能:为了获得更好的性能,可以采取一些优化措施。合理使用块大小,通常块大小设置为128MB或256MB能够得到较好的性能。其次,尽可能地减少数据读写的次数,可以通过合并多个小文件或使用SequenceFile等方式来实现。使用数据本地化技术,使计算节点尽可能地与存储数据的节点靠近,减少数据传输的开销。

7. 监控和管理HDFS:为了确保HDFS的可靠性和稳定性,需要定期监控和管理HDFS集群。Hadoop提供了一些工具,如HDFS Web界面和HDFS命令行界面,用于检查集群的状态、查看文件和目录的信息等。通过这些工具,可以及时发现和解决潜在的问题。

通过正确配置Hadoop集群和HDFS,使用合适的API,配置适当的权限,正确处理异常情况,并采取性能优化措施,你将能够编程使用HDFS进行大数据处理。通过监控和管理HDFS集群,你可以提高集群的可靠性和稳定性。掌握这些技巧和指南,将使你能够更加高效地利用HDFS的强大功能。

版权声明

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。